- Posted by: Tommy Tran

- Sun, 29/01/2023, 8:11 (GMT+7)

- 0 Bình luận

ChatGPT được ca ngợi là một trong những đột phá công nghệ lớn nhất năm qua

Phía sau sự hào nhoáng của ChatGPT là những công nhân phải tiếp xúc nội dung độc hại về bạo lực, tình dục với đồng lương rẻ mạt.

ChatGPT được ca ngợi là một trong những đột phá công nghệ lớn nhất năm qua. OpenAI, nhà phát triển AI này, đang huy động vốn từ nhà đầu tư để nâng định giá công ty lên 29 tỷ USD. Tuy nhiên, phía sau là góc khuất ít người biết. Cuộc điều tra của Time cho thấy để ChatGPT có thể nhanh chóng đưa ra câu trả lời ấn tượng, OpenAI sử dụng những lao động ở Kenya với mức lương ít ỏi cho công việc kiểm duyệt nội dung.

Công việc này đặc biệt quan trọng với OpenAI. Trước ChatGPT, nền tảng GPT-3 đã có thể xâu chuỗi nội dung, nhưng chưa được phát hành rộng rãi vì nó có xu hướng đưa ra những nhận xét bạo lực, phân biệt giới tính, chủng tộc. Đây cũng là vấn đề chung của các mô hình AI, do dữ liệu đầu vào thường được thu thập từ Internet, vốn chứa hàng loạt thông tin độc hại, sai lệch. Ước tính với lượng dữ liệu OpenAI thu thập để huấn luyện trí tuệ nhân tạo, công ty phải cần hàng trăm người làm trong hàng thập kỷ mới có thể rà soát toàn bộ dữ liệu thủ công.

Dùng AI để kiểm soát AI

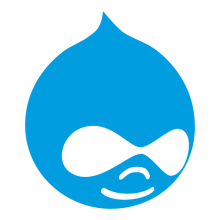

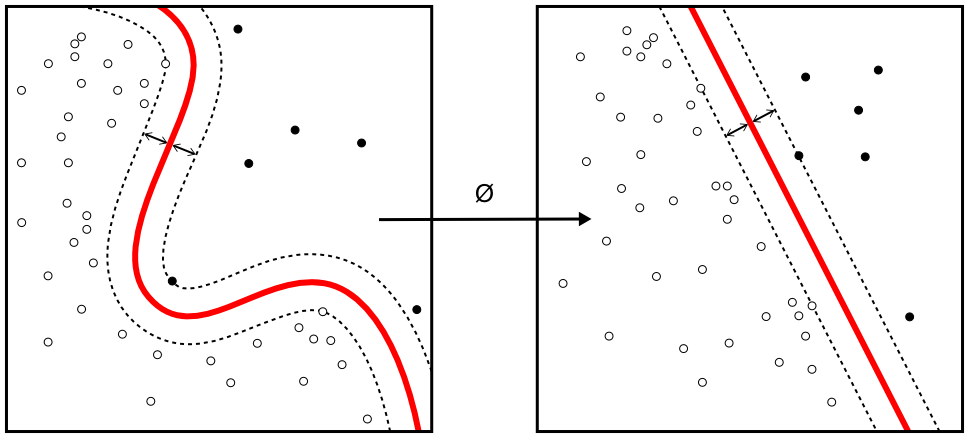

Cách hiệu quả để hạn chế thiên kiến và sai lầm của AI là tạo một cơ chế an toàn bằng AI, tương tự cách những nền tảng lớn như Facebook đã thực hiện. OpenAI đã học tập và xây dựng AI có thể phát hiện ngôn ngữ thù địch để loại bỏ chúng khỏi nền tảng trước khi đem đến cho người dùng những đầu ra "sạch đẹp".

Bài toán khá đơn giản: công ty cung cấp cho AI dữ liệu đầu vào là những ngôn từ mang tính bạo lực, kích động, thù địch, lạm dụng tình dục. Sau khi "tiêu thụ" lượng dữ liệu độc hại này, AI sẽ tự động phát hiện từ khóa, nội dung tương tự. Nền tảng sau đó tích hợp vào ChatGPT để kiểm soát, lọc dữ liệu được cho là không tốt trước khi đến tay người dùng. Nó cũng giúp xóa đi những văn bản độc hại khỏi bộ dữ liệu có sẵn của OpenAI, trước khi đào tạo các mô hình AI trong tương lai.

Câu hỏi đặt ra là làm sao để có được kho dữ liệu độc hại đủ lớn để huấn luyện AI?

Bên kia bờ Ấn Độ Dương, dưới nắng gắt của châu Phi, một công ty gia công phần mềm ở Kenya có đáp án cho câu hỏi này. Sama, đối tác của OpenAI, là cái tên quen thuộc của các công ty lớn ở Thung lũng Silicon như Google, Meta và Microsoft. Họ khẳng định mình là công ty "AI có đạo đức", đã giúp hơn 50.000 người thoát nghèo. Công việc của họ là tìm kiếm nội dung độc hại từ nơi tăm tối nhất của Internet, như những lời mô tả lạm dụng tình dục trẻ em, thú tính, giết người, tự tử, tra tấn, tự làm hại bản thân... để làm phong phú dữ liệu đầu vào cho các đối tác huấn luyện AI.

Sama thay mặt OpenAI trả lương cho những người làm công tác dán nhãn dữ liệu với chi phí từ 1,32 đến 2 USD (31-47 nghìn đồng) mỗi giờ, tùy thâm niên và hiệu suất.

Góc khuất ít người biết

"Trái với vai trò quan trọng họ đang nắm giữ, cuộc sống của các công nhân này luôn bấp bênh, điều kiện làm việc khắc nghiệt", Partnership on AI - Liên minh các tổ chức AI - cho biết.

Người phát ngôn của OpenAI xác nhận công nhân của Sama ở Kenya đóng góp vào công cụ họ đang xây dựng để phát hiện nội dung độc hại, đã được tích hợp vào ChatGPT. "Sứ mệnh của chúng tôi là đảm bảo trí tuệ nhân tạo mang lại lợi ích cho toàn nhân loại và chúng tôi nỗ lực xây dựng hệ thống AI an toàn và hữu ích nhằm hạn chế nội dung thiên vị và có hại. Phân loại, lọc nội dung có hại là bước cần thiết để giảm thiểu bạo lực và tình dục có trong dữ liệu đào tạo", Time dẫn lời phát ngôn viên của OpenAI.

AI được kỳ vọng là tia sáng dẫn dắt ngành công nghệ bước qua thời kỳ ảm đạm. Nhưng điều kiện làm việc của những người dán nhãn dữ liệu cho thấy một phần đen tối trong bức tranh đó. AI đang dựa vào sức lao động của những người có thể đang bị bóc lột, tổn thương với mức lương bèo bọt để đóng góp cho ngành công nghiệp trị giá hàng tỷ USD.

Một nhân viên Sama được giao nhiệm vụ đọc và dán nhãn văn bản cho OpenAI nói với Time rằng anh thường xuyên bị ảo giác sau khi đọc mô tả bằng hình ảnh về một người đàn ông quan hệ tình dục với một con chó trước mặt một đứa trẻ. "Đó là sự tra tấn. Bạn sẽ đọc những nội dung như vậy suốt cả tuần. Cuối tuần, tâm trí bạn như điên đảo khi nhớ lại việc đó. Đây là môi trường làm việc độc hại với chúng tôi", người này nói.

Hợp đồng giữa Sama và OpenAI

OpenAI ký ba hợp đồng tổng trị giá 200.000 USD với Sama cuối năm 2021 để gắn nhãn các mô tả bằng văn bản về lạm dụng tình dục, ngôn từ kích động thù địch và bạo lực. Khoảng ba chục công nhân được chia thành ba đội, mỗi đội tập trung vào từng nhóm nội dung khác nhau. Ba nhân viên kể họ phải đọc và dán nhãn 150-250 đoạn văn bản mỗi ca làm việc kéo dài 9 tiếng. Những đoạn trích đó dài 100-1.000 từ.

Một nhân viên Sama phải đọc câu chuyện về vụ hãm hiếp từ một website khiêu dâm. Sau đó cô phải trải qua bài kiểm tra từ OpenAI xem đây có phải nội dung bạo lực tình dục không. Những bài kiểm tra như vậy là một phần trong công việc của các lao động Sama trước khi được quyền "nuôi dạy AI".

Tất cả nhân viên được phỏng vấn nói họ bị tổn thương tinh thần trầm trọng, dù đã được tham dự một số buổi tư vấn sức khỏe. Người phát ngôn của Sama cho biết các nhà trị liệu sức khỏe được mời đến là những người được đào tạo chuyên nghiệp, có giấy phép hoạt động.

Trong hợp đồng nêu rõ, OpenAI trả 12,5 USD một giờ cho đối tác, tuy nhiên người lao động chỉ nhận được khoảng 1/6 số tiền này. Trung bình mỗi tháng họ kiếm được 170 USD và khoảng 70 USD tiền thưởng nếu đáp ứng các chỉ số về hiệu suất. Nếu làm tăng ca, mỗi người có thể nhận từ 1,32 đến 1,44 USD sau thuế, mức thấp hơn lương tối thiểu của lễ tân ở Kenya.

Người phát ngôn của OpenAI khẳng định công ty không đưa ra bất kỳ mục tiêu năng suất nào và Sama chịu trách nhiệm quản lý điều khoản thanh toán và sức khỏe tâm thần cho nhân viên. "Chúng tôi coi trọng sức khỏe tinh thần của nhân viên và của nhà thầu. Người lao động có thể từ chối công việc mà không bị phạt. Việc tiếp xúc với nội dung tục tĩu sẽ có giới hạn và thông tin nhạy cảm sẽ được xử lý bởi người lao động đã được đào tạo chuyên sâu", đại diện OpenAI nói.

Tuy nhiên, mối quan hệ giữa OpenAI và Sama bắt đầu rạn nứt từ tháng 2/2022. Sama dừng mọi công việc của mình cho OpenAI, sớm tám tháng so với thỏa thuận trong hợp đồng. Công ty gia công phần mềm nói việc thu thập hình ảnh cho OpenAI không được hướng dẫn cụ thể về những gì pháp luật cấm. Sau đó, OpenAI gửi "hướng dẫn bổ sung" nhưng Sama vẫn đưa ra thông báo hủy toàn bộ sự án.

Sau quyết định của Sama, nhóm công nhân bị chuyển đến một sự án trả lương thấp hơn, chuyên phân loại nội dung khiêu dâm với 70 USD mỗi tháng. Do hợp đồng bị hủy, cả OpenAI và Sama đều cho biết khoản tiền 200.000 USD không được thanh toán đầy đủ.

Giới chuyên gia cho biết nhu cầu lao động dán nhãn dữ liệu cho các hệ thống AI sẽ không biến mất khi ngành công nghiệp này ngày càng phát triển. "Chúng rất ấn tượng, nhưng ChatGPT và các mô hình AI không phải là ma thuật, chúng dựa vào chuỗi cung ứng khổng lồ về lao động của con người và nguồn dữ liệu thu thập được", Andrew Strait, một nhà đạo đức học về AI, nói.

Add Comment